Bei Google einen Suchbegriff eingeben? Haben wir schon hunderte Male gemacht. Eine Google-Suche mit einem Bild starten? Auch das machen wir immer öfter. Jetzt ermöglicht Google uns, die Bildsuche mit Texten zu erweitern und so noch zielgerichteter zu suchen. Wie das genau geht und warum es bei dieser Super-Sache noch einen kleinen Haken gibt, wollen wir dir im Folgenden erklären.

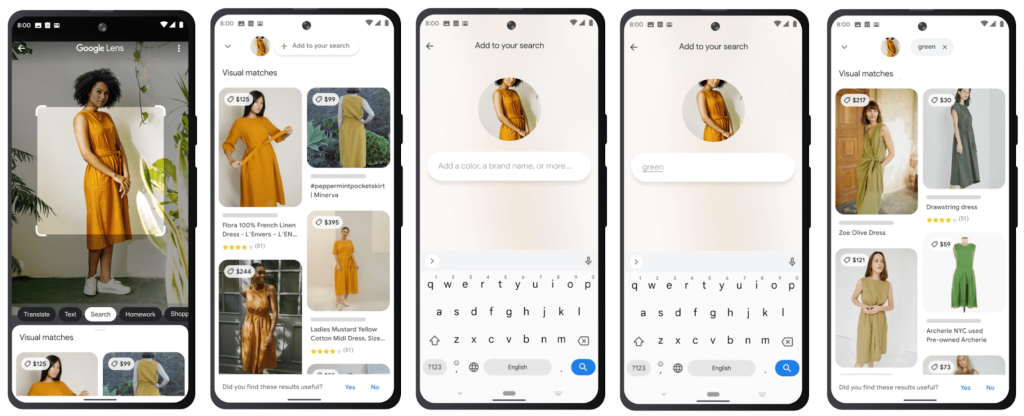

Die Laptoptasche auf dem Nachbartisch sieht toll aus … Wenn es die nur in Blau gäbe. Googles neue Suchfunktion Multisearch macht genau das möglich: Einfach Google Lens öffnen, ein Bild vom gesuchten Gegenstand (z. B. der perfekten Laptoptasche in der falschen Farbe) machen und mit Text versehen (z. B. „blau“). Schon spuckt die KI-basierte Suche Angebote für die Laptoptasche oder ähnliche Produkte in Blau aus. Klingt zu gut, um wahr zu sein? Ist es in Deutschland auch, denn Multisearch ist bisher nur auf Englisch verfügbar. (Aber: Einen kleinen Workaround für die deutschsprachige Suche haben wir dennoch gefunden, mehr dazu weiter unten.) Im Laufe des Jahres soll die Funktion weltweit auf Englisch angeboten werden und in den nächsten Monaten sollen 70 Sprachen hinzukommen. Genaue Informationen, zum Beispiel zu einem deutschen Rollout, gibt es bisher nicht. Wenn die englische Beta-Phase erfolgreich ist, sollte einer deutschen Version aber nichts im Wege stehen.

Kleidung in anderen Farben zu finden, ist ja schön und gut. Aber kann Multisearch auch mehr? Absolut!

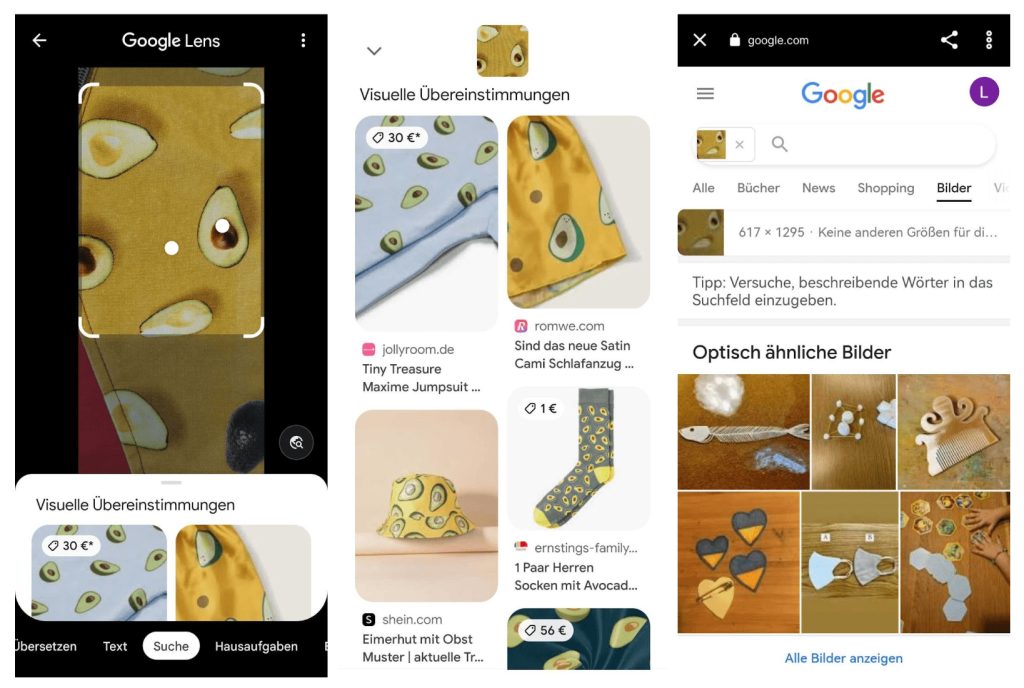

Wie versprochen hier nun der Workaround für all die unter euch, die es (auch) nicht erwarten können: Wer über Google Lens die Bildersuche startet, kann mit dem kleinen Such-Button unten rechts in die Google-Suche springen. Dort kann man dann das Bild mit einem Suchbegriff ergänzen und erhält Bilder, die halbwegs dem Foto und dem Begriff entsprechen. Hier scheint aber keine allzu ausgeklügelte KI eingesetzt zu werden, das zeigt unser Beispiel sehr gut:

Während Google Lens die Avocados auf dem Bild eindeutig als solche identifiziert, scheitert die Google-Suche daran. Die Suche erkennt keine Details, sondern abstrahiert das Bild eher. Soll heißen: Eine gelbe Teekanne finden wir auch in blau und ein Foto von grünem Hintergrund mit dem Suchbegriff “Krawatte” bringt uns grüne Krawatten. Eine Tasche mit dem fotografierten Avocado-Muster findet die Google-Suche allerdings nicht. Als Überbrückung ist dieser Workaround für einfache Suchen eine akzeptable Lösung, aber wir freuen uns dennoch auf den vollen Funktionsumfang von Google Multisearch. Damit wir endlich Krawatten finden, die zum Muster unserer Laptoptaschen passen!

Als wäre die Grundfunktion von Google Multisearch nicht Revolution genug, setzt die Suchmaschine noch einen drauf: Mit einem Bild und der Ergänzung „near me“ (auf Deutsch wohl „in meiner Nähe“) können Nutzer:innen mit dem neuen Update in Google Lens bald Restaurants, Geschäfte und Dienstleister in ihrer Nähe finden. Erinnerst du dich an das Beispiel mit dem Cocktail, dessen Rezept du mit Multisearch findest, ohne den Namen des Drinks zu kennen? Wenn du keine Lust hast, den Cocktail selbst zu mixen, kannst du das Bild mit dem Suchbegriff „near me“ versehen und bekommst Bars in deiner Nähe angezeigt, die diesen Cocktail anbieten. Ähnlich funktioniert das mit Fotos von Essen, Kleidung oder einer Gartenschere. So einfach war Suchen wohl noch nie. Die Funktion soll im späten Herbst in den USA ausgerollt werden und erreicht Deutschland hoffentlich im nächsten Jahr.

Und was kommt als Nächstes? Die Erkennung ganzer Umgebungen statt nur einzelner Bilder. Nehmen wir das Beispiel, das Google selbst in seinem Blog zur Illustration nutzt: Mit der Szenenerkennung in Google Multisearch können Nutzer:innen ein Regal voller Schokoladentafeln scannen. Google Lens blendet in Echtzeit Informationen zu den verschiedenen Schokoladen ein (Bewertungen, Kakaogehalt, Sorten etc.). So wie bei der bereits bekannten Multisearch können wir unsere Suche verfeinern (z. B. mit den Begriffen „dunkel“ oder „ohne Nüsse“). Die Szenenerkennung hebt nun die Tafeln im Regal hervor, die den Suchkriterien entsprechen.

Digitale Informationen in eine echte Umgebung einblenden … Erinnert uns das nicht an etwas? Allerdings!

Die Suchfunktion der Szenenerkennung klingt doch stark nach Augmented-Reality-Anwendungen. Und die funktionieren am besten mit entsprechenden Wearables wie der AR-Brille Google Glass (Anmerkung der Autorin: Dabei handelt es sich nicht um eine Brille, sondern um einen Computer, der nur auf einer Seite genutzt wird. Daher heißt das Google-Produkt tatsächlich Google Glass, nicht Google Glasses, was auch ich erst während der Recherche zu diesem Artikel festgestellt habe. The more you know …)

Das Produkt konnte sich zum Launch 2014 nicht durchsetzen. Die Weiterentwicklung Glass Enterprise Edition 2 bedient vor allem Unternehmen in der Fertigung und Logistik sowie im Gesundheitswesen. Multisearch und die Szenenerkennung könnten das Google Glass wieder zu einer relevanten Größe im Bereich der Wearables und endlich auch für den B2C-Vertrieb interessant machen.

Die gute Nachricht für alle SEOs: Google Multisearch wird die Suchmaschinenoptimierung nicht in ihren Grundfesten erschüttern (*erleichtertes Aufatmen im WEVENTURE-SEO-Team*).

In der Google-Hangouts-Session vom 29.04.2022 stellte Googles Senior Webmaster-Trends-Analyst John Müller klar, dass man als SEO-Manager:in nichts aktiv tun könne, um bei den Multisearch-Suchergebnissen zu erscheinen. Wenn man alles richtig mache und Bilder indexiert sowie Inhalte auffindbar und relevant seien, könne Google die Nutzer:innen bei entsprechenden Suchanfragen zu den Bildern führen.

Also tun wir weiter, was wir schon immer getan haben: Wir nutzen relevante Bilder an sinnvollen Stellen (gerne auch im Fließtext), versehen sie mit aussagekräftigen Titeln und Alt-Texten und fügen passende Keywords ein. Von sinnlosem, weil kontraproduktivem Keyword-Stuffing nehmen wir natürlich ebenso Abstand wie von anderen Blackhat-SEO-Strategien.

Ein kleines Manko sehen unsere SEO-Manager:innen allerdings: Aktuell lässt sich Traffic über Multisearch nicht separat tracken, sondern wird dem Kanal „Direct Traffic” zugeordnet. Das macht eine saubere und trennscharfe Traffic-Auswertung leider unmöglich … Wir hoffen, dass Google das korrigiert, bevor die Anwendung weiter ausgerollt wird.

In meinen Augen ermöglicht Multisearch genau das, was Googles Senior Vice-President Prabhakar Raghavan als Ziel der Anwendung beschreibt: Wir können so suchen, wie wir es im echten Leben auch tun. Zumindest teilweise. Wir können optische Eindrücke mit konkreten Fragen kombinieren und so eine tatsächlich relevante Antwort auf unsere Frage erhalten.

Alle Google-typischen Datenbedenken einmal beiseite geschoben, bin ich Fan der Multisearch. Wenn die Beta-Version erfolgreich getestet und international ausgerollt wird, können wir uns auf eine „Search Revolution“ einstellen: weil Suchergebnisse echte Sucherlebnisse werden. Meiner Meinung nach bezeichnet Google seine Multisearch-Funktion zurecht als eines der „bedeutendsten Updates für die Google Suche seit mehreren Jahren“.

Mich interessieren besonders die Möglichkeiten, die uns die Szenenerkennung bieten wird. Wer stand denn noch nie völlig überfordert vor einem Regal im Baumarkt und wusste nicht, welche Lasur, Schraube oder Rohrschelle die richtige für das anstehende Projekt ist? Google könnte solche Probleme in Zukunft lösen. Denn dann stehen zwar zehn Leute im Gang und richten ihre Smartphone-Kamera auf das Schraubenregal. Aber wenigstens kann Google Lens so auch die Kund:innenzufriedenheit ordentlich nach oben schrauben.

Google liefert mit Multisearch und den Erweiterungen (darunter lokale Informationen sowie Szenenerkennung) eine echte Innovation für die Google-Suche. Wir sind gespannt, wann Multisearch auf Deutsch verfügbar sein wird und ob die Funktion auch Google Glass neues Leben einhauchen wird.